Apple utiliza la pornografía infantil para normalizar el espionaje tecnológico

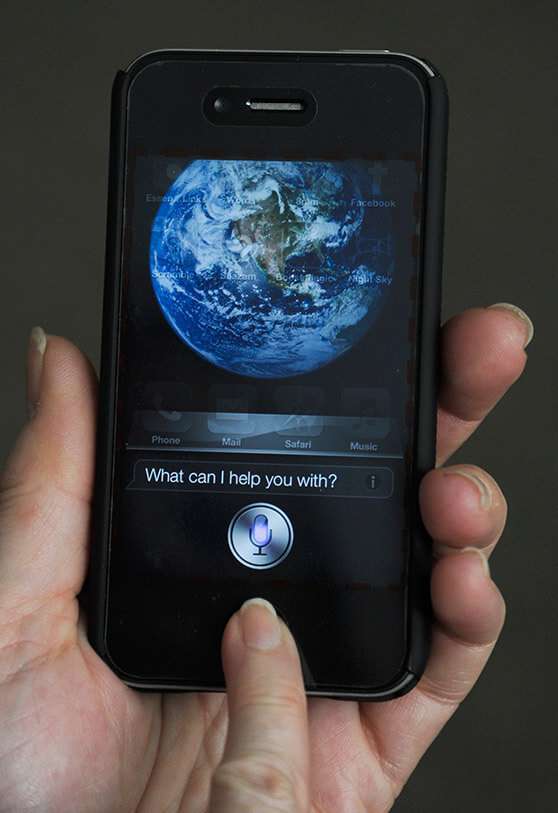

“Apple suspende el programa por el que terceros escuchaban tus conversaciones con Siri”, rezaba un titular en agosto de 2019. La noticia aclaraba que trabajadores de la compañía reconocieron en declaraciones a The Guardian que habían llegado a escuchar conversaciones sobre sexo o drogas. Meses más tarde llegó la campaña que transformaba el logo de la manzana mordida en un candado y aseguraba que “lo que pasa en tu iPhone, se queda en tu iPhone”.

En agosto de 2021 Apple ha abierto una peligrosa caja de truenos en su último comunicado. Un documento de 12 páginas en las que explica que desde ahora Apple va a escanear las imágenes que almacenan los usuarios en iCloud. También hay dos medidas más que quiere desarrollar, una es la capacidad de avisar de material “sensible” en Messages y otra es la opción que el dispositivo avise cuando Siri o Search ofrezcan soluciones inseguras o los usuarios busquen información sobre pornografía infantil.

En el fondo, la idea de Apple puede ser buena y hasta necesaria en la sociedad en la que vivimos. Todos conocemos las historias de monstruos que abusado de niños. Cada cierto tiempo la Policía desactiva mafias que trafican con imágenes de menores. Y fuera de esa inocencia nos encontramos con lobos de WhatsApp pidiendo fotos a menores para luego cometer chantajes. Bueno, pues toda esa realidad insoportable choca de frente con la seguridad que merecemos tener en nuestro entorno tecnológico.

Hay dos posiciones respecto a la intención de Apple. Una es sentirse libre y seguro porque no hay nada que esconder, incluso tener algo delicado pero legal. No tener miedo a que roben las fotos del móvil porque no hay nada de lo que avergonzarse ni nada con lo que arruinar una vida. Los pederastas o las mafias que se dedican a la pornografía infantil se cuidan mucho de no guardar esas imágenes en cualquier servidor. Apple va directamente a por los enfermos que hacen esas fotos y trafican con ellas. Los lobos con piel de cordero que utilizan su posición, su empleo o la confianza de otros para conseguir material. Los sumarios de los casos más turbios de pederastia cuentan qué tipo de perfiles tienen acceso a hacer esas fotografías. Pone los pelos de punta saber ciertas cosas y Apple ha decidido entrar en esos teléfonos para atrapar a los malos.

Hay dos posiciones respecto a la intención de Apple. Una es sentirse libre y seguro porque no hay nada que esconder, incluso tener algo delicado pero legal. No tener miedo a que roben las fotos del móvil porque no hay nada de lo que avergonzarse ni nada con lo que arruinar una vida. Los pederastas o las mafias que se dedican a la pornografía infantil se cuidan mucho de no guardar esas imágenes en cualquier servidor. Apple va directamente a por los enfermos que hacen esas fotos y trafican con ellas. Los lobos con piel de cordero que utilizan su posición, su empleo o la confianza de otros para conseguir material. Los sumarios de los casos más turbios de pederastia cuentan qué tipo de perfiles tienen acceso a hacer esas fotografías. Pone los pelos de punta saber ciertas cosas y Apple ha decidido entrar en esos teléfonos para atrapar a los malos.

Pero los de Cupertino van a poner en marcha una acción que pone en riesgo a sus clientes. A los que les dice que sus móviles, ordenadores o tablets son las más seguras del mercado. A esos usuarios les intenta explicar que han diseñado una tecnología punta que va a convertir sus fotos en números y que va a comparar esos números con los de imágenes de pornografía infantil y que si coinciden le van a denunciar a la Policía. Apple se toma demasiado en serio su papel de detective privado. Pone en riesgo la confianza es su sistema operativo para obtener un resultado que se prevé muy reducido.

Todo lo que explica Apple en su pdf se reduce a que escaneará las fotos de los usuarios que tengan activado iCloud Photos. Es decir, que no hay opción a desactivar el “fingerprinting” como lo califica Apple. En el caso de Messages, aseguran que “todo queda en familia” por lo que Apple monitorizará los móviles de los menores que pertenezcan a una cuenta familiar. En este caso es una opción “opt-in”, solo se activa si el usuario lo indica. Los padres recibirán un aviso cuando sus hijos manden o reciban fotos comprometidas, pero no lo comunicarán a las autoridades. En España no tendrán que trabajar mucho ese campo porque la obsesión que hay por WhatsApp hace que apenas se utilicen los mensajes de texto entre dispositivos Apple, aunque sea gratis y, hasta ahora, más seguro.

Apple no va a solucionar la lacra de la pornografía infantil con esta medida. Eso lo harán las autoridades con el gran trabajo que realizan cada día. Desactivando mentes enfermas y encerrando a esos monstruos que hacen una vida aparentemente normal. La campaña de Apple tiene mucho de marketing. Mucha forma y poco fondo. Que logren señalar a un solo abusador es una buena noticia, pero si por el camino señalan a unos cuantos inocentes, porque su Inteligencia Artificial ha fallado o pierden esa imagen de seguridad, no habrá valido la pena porque ese delincuente habría caído gracias al trabajo policial.

Apple no quiso desbloquear un iPhone 4 para obtener más información sobre los terroristas de Boston. Ahora proclama que es capaz de entrar en los móviles, revisar las fotos sin ver el contenido y detectar las que sean de pornografía infantil. Es un campo de minas que acabará en los tribunales porque es impopular decir que buscar ese tipo de imágenes hoy no puede justificar atacar la libertad de expresión mañana.