Apple utilise la pédopornographie pour normaliser l'espionnage technologique

"Apple suspend le programme grâce auquel des tiers écoutaient vos conversations avec Siri", pouvait-on lire en août 2019. La nouvelle a précisé que les employés de l'entreprise ont reconnu dans des déclarations au Guardian qu'ils étaient venus pour écouter des conversations sur le sexe ou la drogue. Quelques mois plus tard est venue la campagne qui a transformé le logo de la pomme mordue en un cadenas et assuré que "ce qui se passe sur votre iPhone, reste sur votre iPhone".

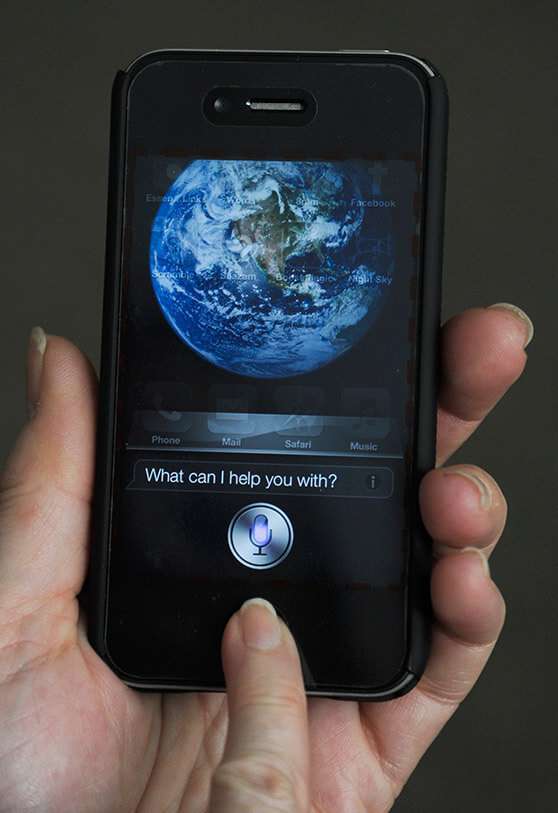

En août 2021, Apple a ouvert une dangereuse boîte de Pandore dans son dernier communiqué de presse. Un document de 12 pages dans lequel il explique que dorénavant Apple scannera les images que les utilisateurs stockent dans iCloud. Il y a également deux autres mesures qu'il veut développer, l'une est la possibilité d'avertir du contenu "sensible" dans Messages et l'autre est l'option pour l'appareil d'avertir lorsque Siri ou Search proposent des solutions dangereuses ou que les utilisateurs recherchent des informations sur la pédopornographie.

Au final, l'idée d'Apple est peut-être bonne, et même nécessaire dans la société dans laquelle nous vivons. Nous connaissons tous les histoires de monstres qui abusent des enfants. De temps en temps, la police démantèle des mafias qui trafiquent des images de mineurs. Et à partir de cette innocence, nous trouvons des loups sur WhatsApp qui demandent des photos de mineurs pour ensuite faire du chantage. Eh bien, toute cette réalité insupportable se heurte de plein fouet à la sécurité que nous méritons d'avoir dans notre environnement technologique.

Il y a deux positions concernant l'intention d'Apple. La première est de se sentir libre et en sécurité car il n'y a rien à cacher, même pour avoir quelque chose de sensible mais de légal. Ne pas avoir peur de se faire voler les photos de son téléphone portable, car il n'y a pas de quoi avoir honte ni de quoi gâcher une vie. Les pédophiles ou les mafias de la pédopornographie font très attention à ne pas enregistrer ces images sur un quelconque serveur. Apple s'en prend directement aux malades qui prennent ces photos et en font le trafic. Les loups déguisés en moutons qui utilisent leur position, leur emploi ou la confiance des autres pour obtenir du matériel. Les résumés des affaires de pédophilie les plus louches indiquent quels types de profils ont accès à ces photos. Il est un peu angoissant de savoir certaines choses, et Apple a décidé de s'introduire dans ces téléphones pour attraper les méchants.

Il y a deux positions concernant l'intention d'Apple. La première est de se sentir libre et en sécurité car il n'y a rien à cacher, même pour avoir quelque chose de sensible mais de légal. Ne pas avoir peur de se faire voler les photos de son téléphone portable, car il n'y a pas de quoi avoir honte ni de quoi gâcher une vie. Les pédophiles ou les mafias de la pédopornographie font très attention à ne pas enregistrer ces images sur un quelconque serveur. Apple s'en prend directement aux malades qui prennent ces photos et en font le trafic. Les loups déguisés en moutons qui utilisent leur position, leur emploi ou la confiance des autres pour obtenir du matériel. Les résumés des affaires de pédophilie les plus louches indiquent quels types de profils ont accès à ces photos. Il est un peu angoissant de savoir certaines choses, et Apple a décidé de s'introduire dans ces téléphones pour attraper les méchants.

Mais Cupertino va prendre une mesure qui met ses clients en danger. Ceux à qui l'on dit que leurs mobiles, ordinateurs ou tablettes sont les plus sécurisés du marché. À ces utilisateurs, il tente d'expliquer qu'il a conçu une technologie de pointe qui va convertir leurs photos en chiffres et qu'il va comparer ces chiffres avec ceux des images de pornographie enfantine et que, s'ils coïncident, il va les signaler à la police. Apple prend son rôle de détective privé trop au sérieux. Il met en péril la fiabilité de son système d'exploitation afin d'obtenir un résultat qui devrait être très faible.

Tout ce qu'Apple explique dans son pdf, c'est qu'il va scanner les photos des utilisateurs qui ont activé iCloud Photos. En d'autres termes, il n'y a pas d'option pour désactiver l'empreinte digitale, comme l'appelle Apple. Dans le cas de Messages, on dit que "tout reste dans la famille". Apple surveillera donc les mobiles des mineurs appartenant à un compte familial. Dans ce cas, il s'agit d'une option "opt-in", activée uniquement si l'utilisateur l'indique. Les parents recevront un avertissement lorsque leurs enfants enverront ou recevront des photos compromettantes, mais ne préviendront pas les autorités. En Espagne, ils n'auront pas à faire beaucoup d'efforts dans ce domaine, car l'obsession de WhatsApp fait que la messagerie texte entre appareils Apple est à peine utilisée, alors qu'elle est gratuite et, jusqu'à présent, plus sûre.

Ce n'est pas avec cette mesure qu'Apple va résoudre le fléau de la pédopornographie. Ce sera fait par les autorités avec le grand travail qu'elles font chaque jour. Désarmer les esprits malades et enfermer ces monstres qui vivent une vie apparemment normale. La campagne d'Apple fait la part belle au marketing. Beaucoup de forme et peu de substance. S'ils parviennent à identifier un seul agresseur, c'est une bonne nouvelle, mais si, en cours de route, ils identifient quelques innocents, parce que leur IA a échoué ou qu'ils perdent cette image de sécurité, cela n'aura pas valu la peine, car l'agresseur aura été arrêté grâce au travail de la police.

Apple n'a pas voulu déverrouiller un iPhone 4 pour obtenir plus d'informations sur les terroristes de Boston. Aujourd'hui, elle prétend pouvoir s'introduire dans des téléphones portables, examiner des photos sans en regarder le contenu et détecter la pédopornographie. C'est un champ de mines qui finira devant les tribunaux parce qu'il est impopulaire de dire que la recherche de telles images aujourd'hui ne peut justifier une atteinte à la liberté d'expression demain.